此前,我们展示了8片PBlaze6 6920系列企业级SSD搭配GRAID SupremeRAID SR-1010 NVMe加速卡,组建Raid5之后的本地性能:得益于PBlaze6 6920自身强悍的读写能力以及SR-1010数以千计的加速核心,为整个Raid阵列带来了1100万IOPS的4K随机读性能、近50GB/s的顺序读带宽,Raid5模式下的写入效率也得到了显著提升。

FC SAN光纤通道存储区域网络是让多个服务器能够高速访问网络存储设备的系统,它让存储设备的存储容量、IO性能可以在终端业务部署中得到充分利用,也是当今企业IT架构的一种典型部署方式。

那么,当PBlaze6 6920 Raid阵列遇到FC SAN,其性能表现又会如何?本次测试,将带来解答。

注:本次测试在知名存储网站/测试机构StorageReview实验室进行,测试结果也已在StorageReview网站发布,所有测试结果、文章配图,均来自StorageReview。

查看原文,请访问:https://www.storagereview.com/review/starwind-san-nas-over-fibre-channel

本次测试所用的8片企业级SSD依旧为Memblaze PBlaze6 6920的12.8TB容量点,它是面向混合读写业务场景打造的高性能PCIe 4.0 NVMe SSD,有着高达1600K IOPS的4K随机读性能,500K IOPS的4K随机写性能,顺序读/写带宽分别为7GB/s和6.7GB/s。

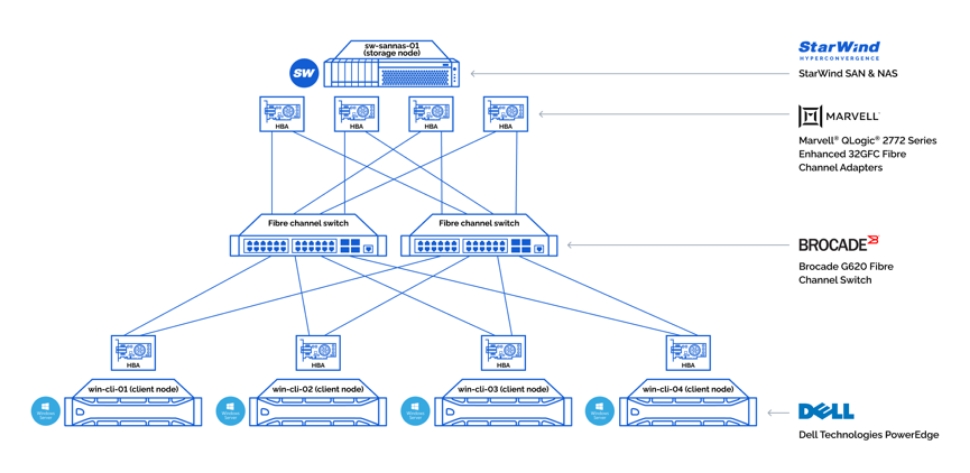

为尽可能发挥8盘并发的强悍性能,存储节点选择了Dell PowerEdge R750服务器。它配备两颗第三代Intel Xeon Scalable 8380处理器、1TB DDR4内存,配备GRAID SupremeRAID SR-1010 Raid卡,软件为StarWind SAN & NAS 1.0.2版本。

StarWind是SDS(软件定义存储)技术供应商,在StarWind SAN & NAS 1.0.2版本中,加入了FC高速网络,以及GRAID NVMe加速卡的支持。

客户节点采用了Dell PowerEdge R740xd服务器,配备两颗Intel Xeon Gold 6130处理器,256GB内存,运行Windows Server 2019操作系统。

网络方面,存储节点和客户节点通过Marvell QLogic 2772 32GFC光纤网卡进行连接。其中,存储节点部署4张,每个客户节点配备1张。存储节点和客户节点之间使用两台Brocade G620光纤交换机以保证弹性。

最终,测试环境的软硬件架构如下:

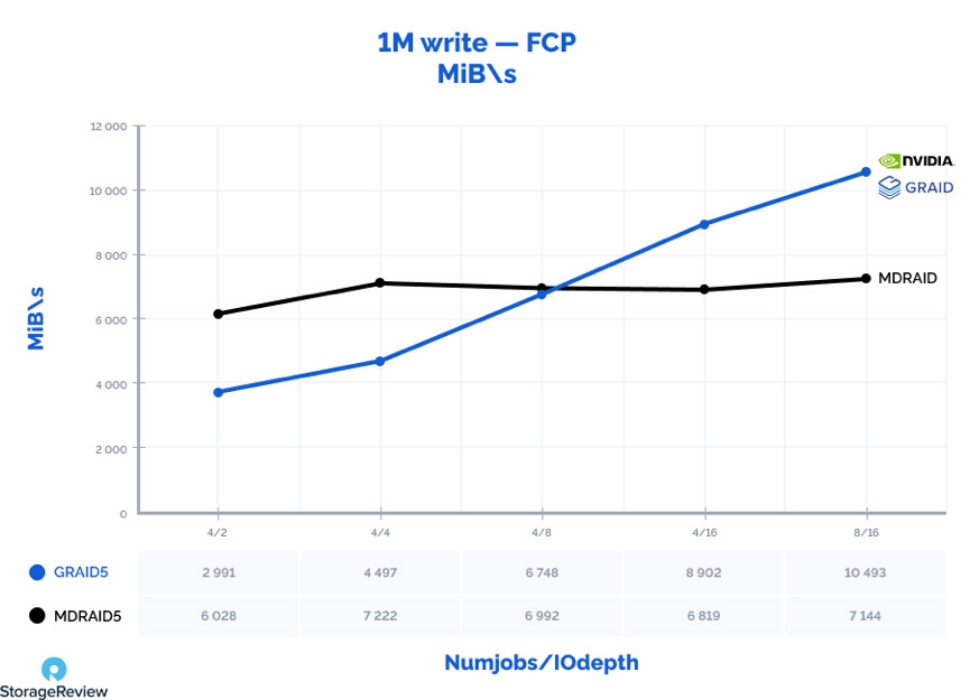

注1:受实验室设备限制,8块32GFC光纤网卡的总带宽为32Gb x 8,也就是25.6GB/s,低于8片NVMe SSD总的接口带宽,会对远程测试结果带来一定影响。

注2:尽管GRAID SupremeRAID SR-1010采用PCIe 4.0 x16接口,但受到服务器条件限制,只能使用x8接口,会对写入性能带来一定影响。

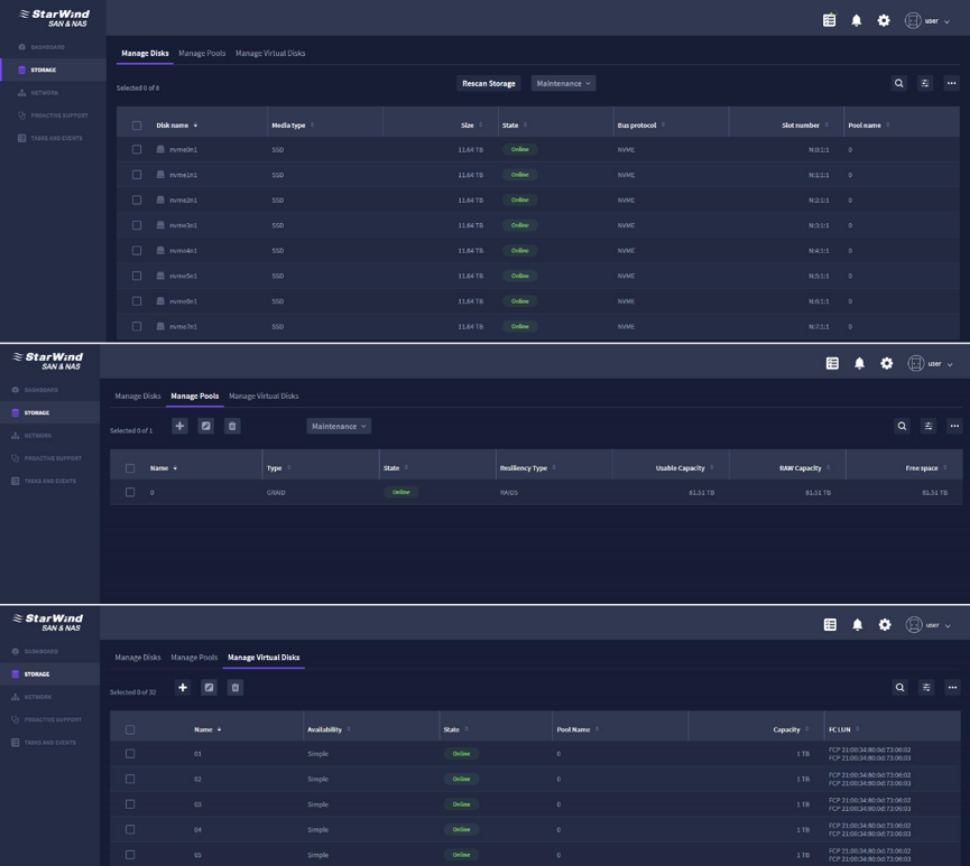

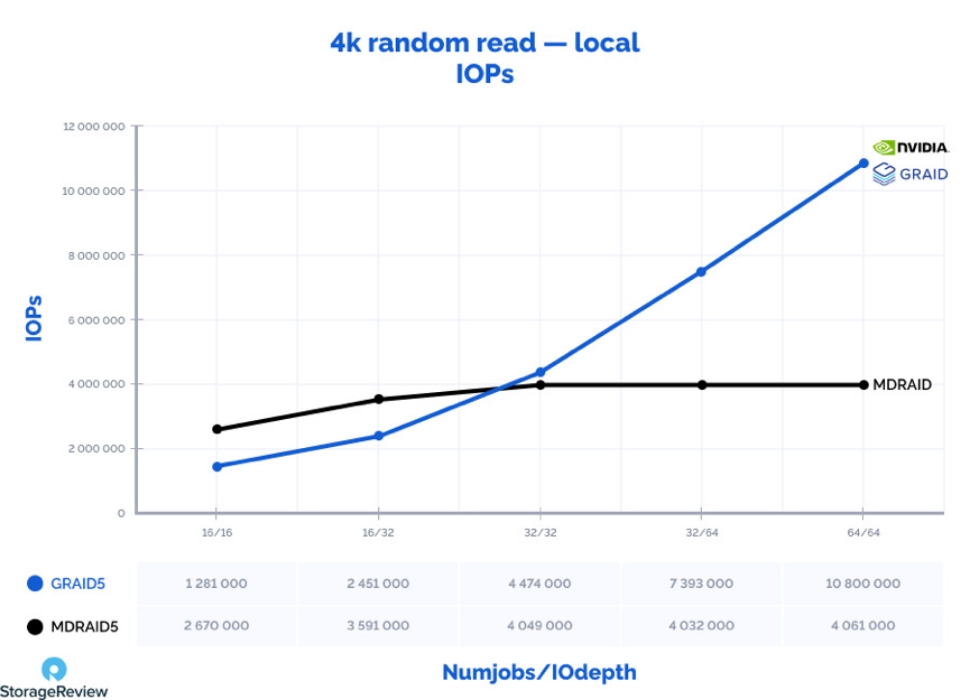

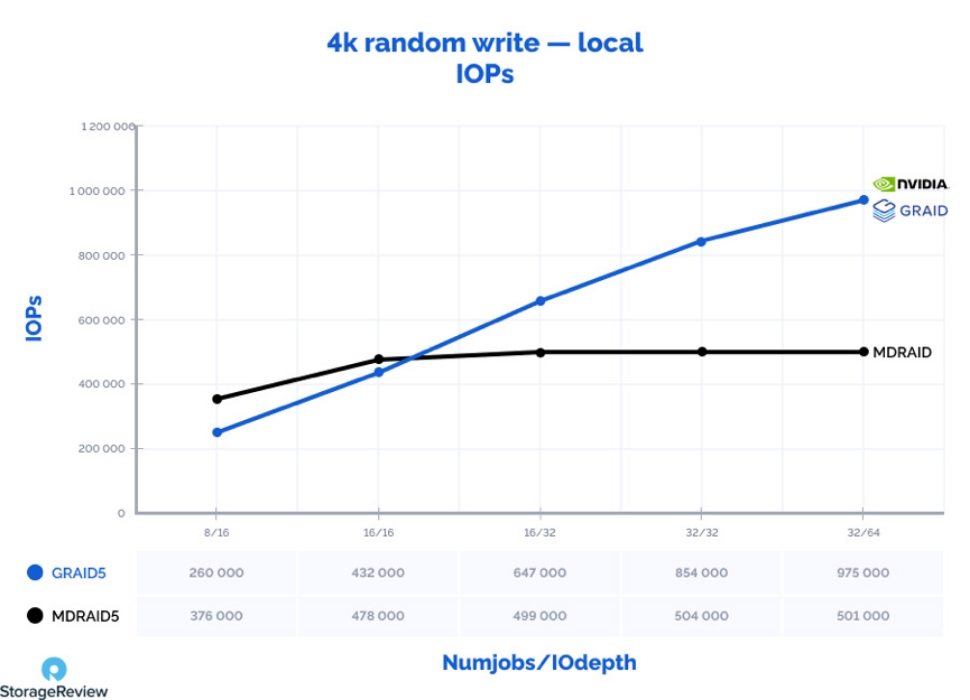

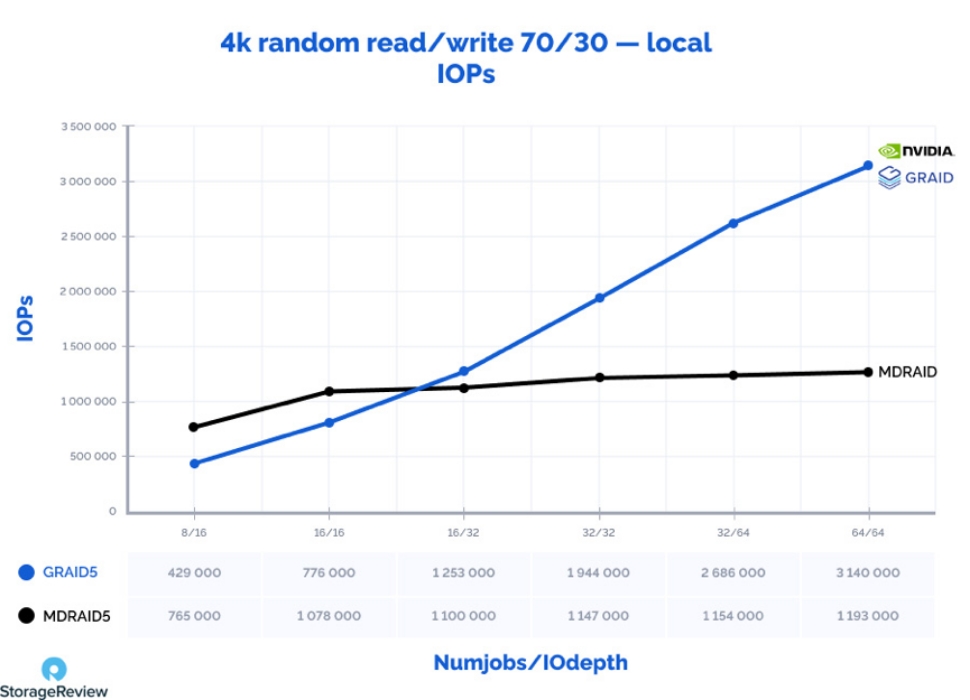

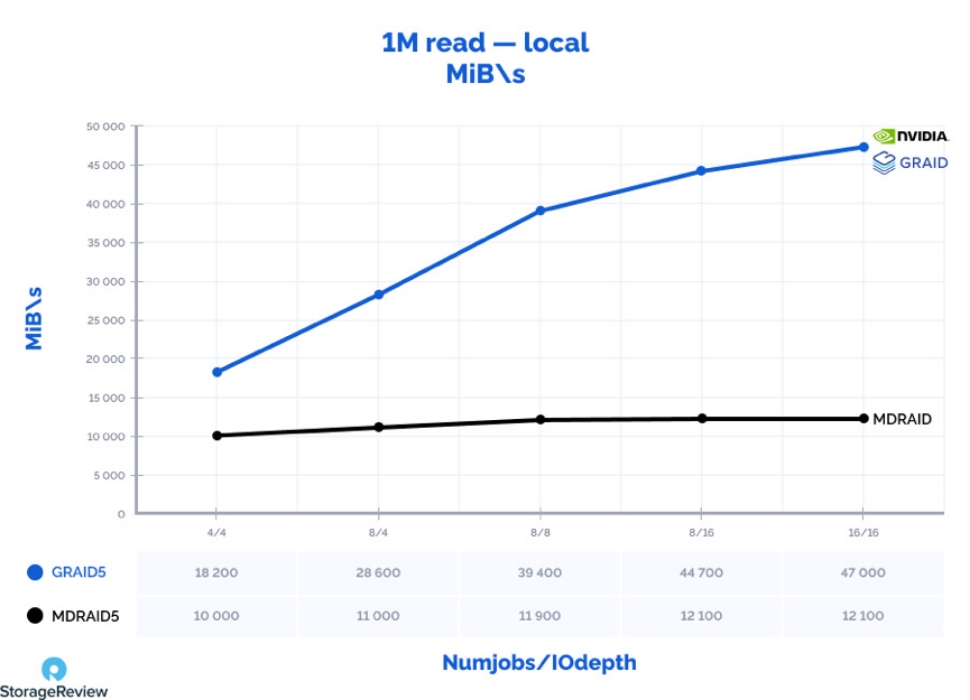

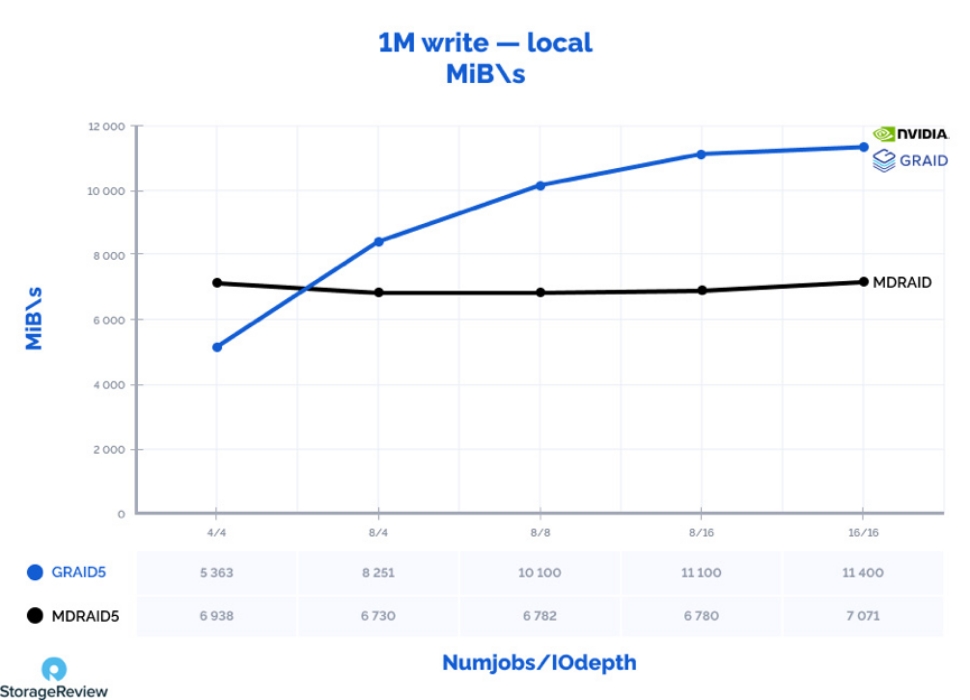

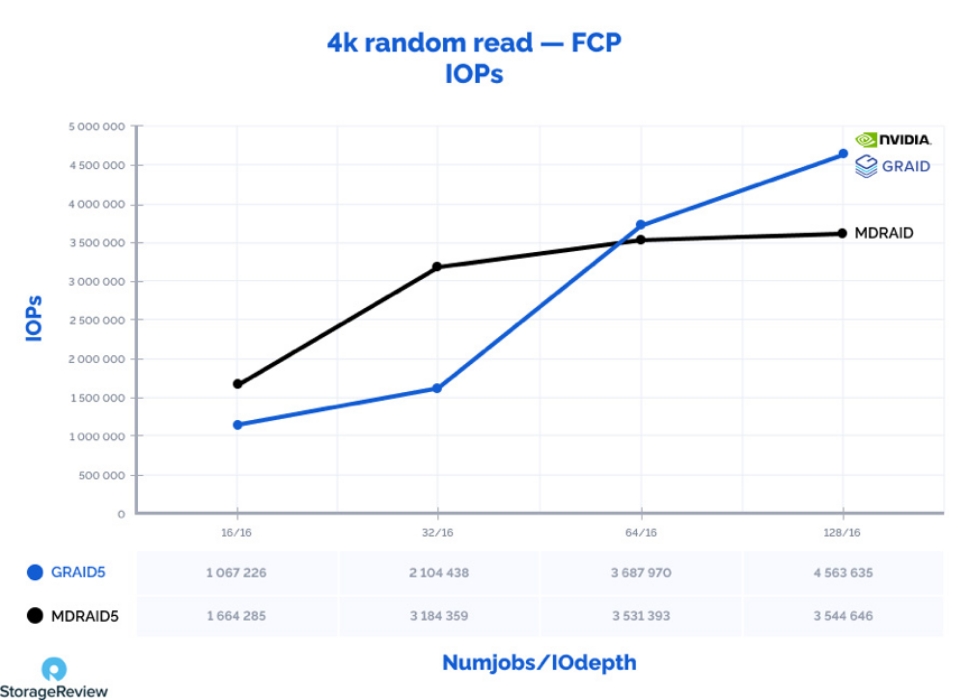

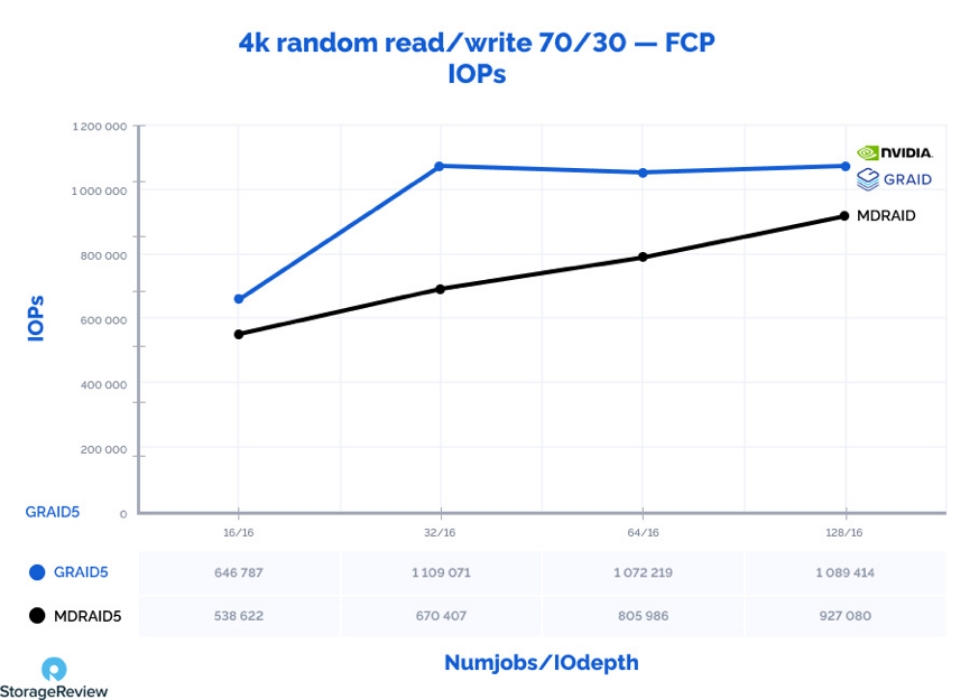

整个测试分为两个阶段,第一阶段基于StarWind SAN & NAS软件框架,进行存储节点的本地存储性能测试 —— 分别基于GRAID SR-1010 NVMe加速卡(为方便理解,以下简称为“硬件Raid”)和软件Raid技术(以下简称“软件Raid”),创建由8片PBlaze6 6920企业级SSD以Raid5的方式构建的存储池,以此对比硬件Raid和软件Raid的性能。

第二阶段进行FC SAN架构下的远程性能测试。存储节点设置不变,通过高速网络,由4台客户节点同时发起存储负载测试,以考量客户节点可以获得的最终性能。本测试环节同样会对比硬件Raid和软件Raid的性能。

测试软件为FIO,测试项目包括:

每个测试环节持续时间为600秒,在写入性能测试之前,还会先进行2个小时的SSD预热,使其进入稳态,避免对测试结果带来影响。

在本地测试过程中,硬件Raid随着IO压力的不断增大,其性能呈现出了不断增加的趋势,同时在写入操作中CPU占用率更低,相比软件Raid优势非常明显。接下来是FC SAN环境下的远程测试。

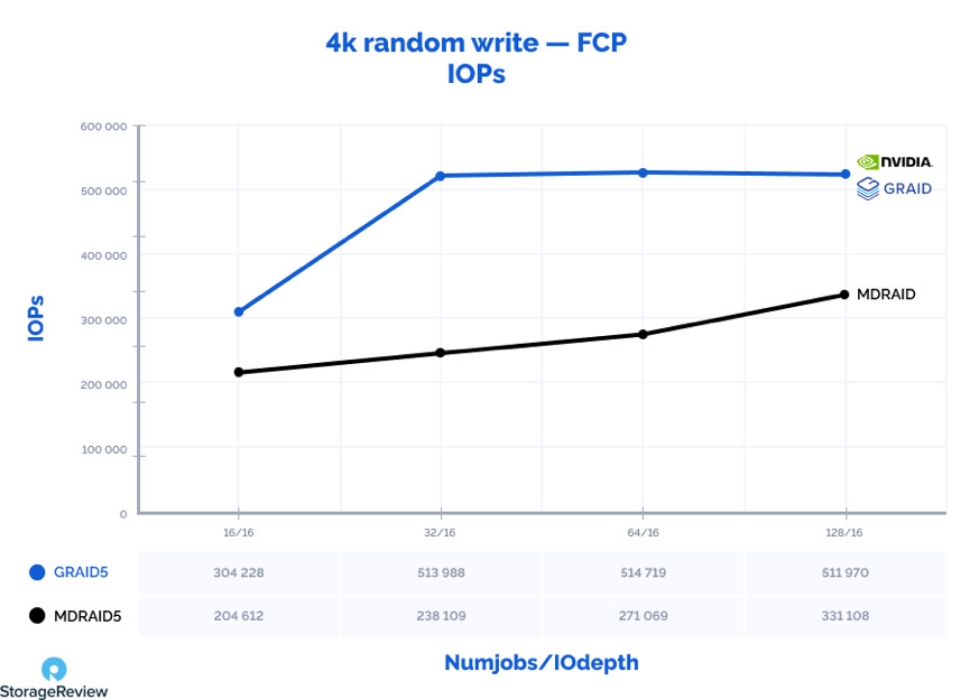

随着IO压力的增加,软件Raid的4K随机写性能从204K IOPS逐渐提升至385K(T128/Q32);

与之相比,硬件Raid的4K随机写性能从304K提升至498K,性能优势明显。

通过本次测试,PBlaze6 6920系列企业级SSD在大压力下的性能表现依旧让人印象深刻。同时,由GRAID NVMe加速卡带来的Raid效率提升,即使在远程访问下也能带给用户较高收益,在高速网络的支持下为终端应用带来充足的性能。本次测试只是一个缩影,随着未来网络技术的不断发展和专用数据处理单元的加入,未来高性能PCIe SSD也定将在企业业务应用中发挥更大价值!

GPU Raid 卡加持!PBlaze6 6920 挑战8盘 Raid5